DAGOREPORT - MENTRE LA PROCURA DI MILANO, DOPO AVER ISCRITTO SUL REGISTRO DEGLI INDAGATI…

"INTELLIGENZA" ARTIFICIALE SOLO PER MODO DI DIRE - UN TEAM DI RICERCATORI È RIUSCITO A "FREGARE" CHATGPT E FARGLI RIVELARE ALCUNI DEI DATI SU CUI È STATO ADDESTRATO, INCLUSI NUMERI DI TELEFONO E INDIRIZZI EMAIL, USANDO UN SEMPLICE TRUCCO - I RICERCATORI HANNO CHIESTO AL "BOT" DI RIPETERE PAROLE CASUALI ALL'INFINITO, PORTANDOLO A SCOPERCHIARE I DATI SENSIBILI CHE USA PER PROCESSARE GLI INPUT DI INFORMAZIONI: "È ASSURDO QUESTA FALLA DOVEVA ESSERE SCOPERTA PRIMA" - A PREOCCUPARE È IL FATTO CHE QUALSIASI MALINTENZIONATO POTREBBE…

(ANSA) - Un team di ricercatori è riuscito a far rivelare a ChatGpt - che proprio ieri ha compiuto un anno di vita - alcuni dei dati su cui è stato addestrato, inclusi numeri di telefono e indirizzi email. Il tutto con un escamotage abbastanza banale: chiedere al chatbot di ripetere parole casuali all'infinito. Con questo sistema, quasi 1 test su 5 (il 16,9%) è andato a buon fine. "È assurdo questa falla doveva essere scoperta prima", le parole dei ricercatori che l'hanno individuata e che lavorano presso Google Deepmind, l'Università di Washington, la Cornell di New York, la Carnegie Mellon della Pennsylvania, la Berkley e l'Eth di Zurigo.

In un documento congiunto, pubblicato online e ripreso da 404 Media, gli esperti esortano le aziende che sviluppano servizi di IA a eseguire più test prima di rilasciare i loro modelli linguistici. "Ci sembra assurdo che il nostro attacco funzioni visto che si sarebbe dovuto scoprire e chiudere prima" scrivono. Intanto, proprio in queste ore, il papà di ChatGpt, Sam Altman, ha rilasciato un'intervista al sito The Verge, in cui non spiega i motivi del suo allontanamento da OpenAi, limitandosi a dire di essere tornato "per aiutare a sviluppare un'Agi sicura e vantaggiosa".

L'Agi è l'intelligenza artificiale di nuova generazione, idealmente la versione 5 del modello Gpt su cui si basa ChatGpt, che dovrebbe avvicinare ulteriormente la conoscenza degli algoritmi a quella dell'uomo, rendendo i chatbot quasi del tutto indistinguibili, nello scrivere e parlare, dagli esseri umani. Tornando alla scoperta dei ricercatori, quando questi hanno chiesto a ChatGpt di ripetere la parola "poesia", il chatbot inizialmente ha dato seguito alla domanda, finendo poi per rivelare un vero indirizzo email e un numero di telefono.

Stessa cosa con "azienda", che ha permesso di avere l'indirizzo email e il numero di uno studio legale negli Stati Uniti. Per i ricercatori, un utente malintenzionato potrebbe spendere poche centinaia di dollari per acquistare un piano premium di ChatGpt e ricavare migliaia di informazioni da sfruttare per le sue campagne hacker.

DAGOREPORT - MENTRE LA PROCURA DI MILANO, DOPO AVER ISCRITTO SUL REGISTRO DEGLI INDAGATI…

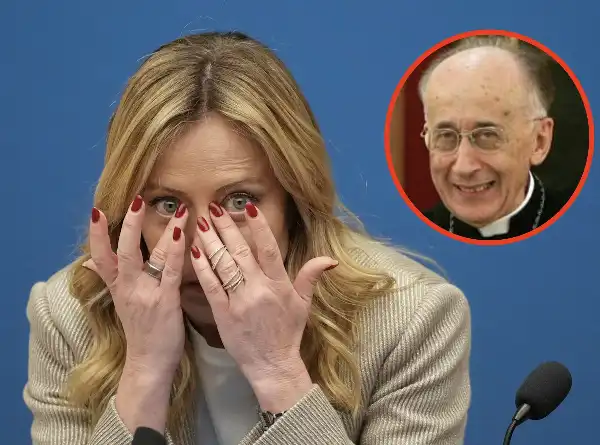

FLASH – PERCHÉ GIORGIA MELONI HA UN INFERMIERE CHE ABITUALMENTE VA DA LEI? IL CARDINAL CAMILLO…

DAGOREPORT – COSA, E CHI, HA CONVINTO SERGIO MATTARELLA A PRESIEDERE, PER LA PRIMA VOLTA IN 11 ANNI…

DAGOREPORT – A FORZA DI FARE IL "MAGGIORDOMO" DI CASA MELONI, ANTONIO TAJANI È FINITO IN CUL DE SAC …

FLASH! – IERI È STATO SVENTATO IL PROPOSITO DI GIAMPAOLO ROSSI DI DIMETTERSI DAL VERTICE DEL…

DAGOREPORT – NEL GRAN POLLAIO DELLE ELEZIONI PRESIDENZIALI FRANCESI DEL 2027 NON POTEVA MANCARE…