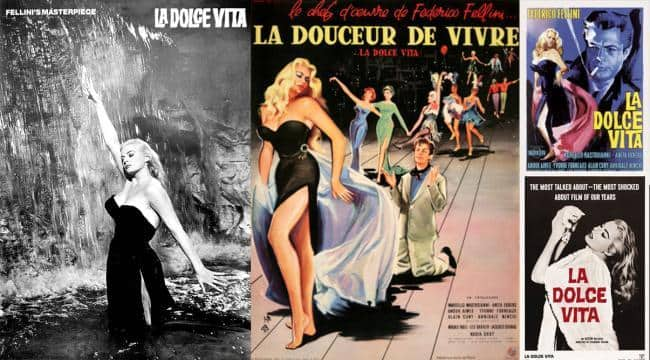

Articolo del “Financial Times" - dalla rassegna stampa estera di "Epr Comunicazione"

facebook

facebook

Gli appaltatori in Kenya revisionano i contenuti grafici in modo che gli utenti non debbano farlo. Ora fanno causa a Meta per ottenere un accordo più equo

Nel suo lavoro, ha dovuto guardare un nuovo video di Facebook ogni 55 secondi circa, rimuovendo e classificando i contenuti grafici più dannosi. Il primo giorno ricorda di aver vomitato per la repulsione dopo aver visto il video di un uomo che si uccideva davanti al figlio di tre anni. Scrive il Financial Times.

Poi le cose sono peggiorate. "C'è la pedopornografia, la bestialità, la necrofilia, i danni agli esseri umani, agli animali, gli stupri", dice, con la voce che gli trema. "Non è una cosa che si può vedere su Facebook come utente. Il mio compito come moderatore è quello di assicurarmi che non lo vediate".

moderatori facebook 1

moderatori facebook 1

Dopo un po', dice, gli orrori incessanti cominciano a influenzare il moderatore in modi inaspettati. "Dopo aver visto 100 decapitazioni, si arriva a un punto in cui si inizia a sperare che la prossima sia più raccapricciante. È una specie di dipendenza".

Brownie è una delle centinaia di giovani, per lo più ventenni, che sono stati reclutati da Sama, una società di outsourcing con sede a San Francisco, per lavorare nel suo hub di Nairobi alla moderazione dei contenuti di Facebook.

moderatori

moderatori

Sudafricano, fa ora parte di un gruppo di 184 firmatari di una causa contro Sama e Meta, società proprietaria di Facebook, per presunte violazioni dei diritti umani e per l'ingiusta risoluzione dei contratti.

Il caso è uno dei più grandi del suo genere in tutto il mondo, ma uno dei tre in corso contro Meta in Kenya. Insieme, hanno implicazioni potenzialmente globali per le condizioni di lavoro di un esercito nascosto di decine di migliaia di moderatori impiegati per filtrare il materiale più tossico dai social network del mondo, dicono gli avvocati.

Nel 2020, Facebook ha sborsato 52 milioni di dollari per risolvere una causa e fornire cure mentali ai moderatori americani. Altre cause intentate da moderatori in Irlanda hanno chiesto un risarcimento per presunti disturbi da stress post-traumatico.

the trauma floor la vita segreta dei moderatori di facebook

the trauma floor la vita segreta dei moderatori di facebook

I casi kenioti sono i primi presentati al di fuori degli Stati Uniti che cercano di cambiare, attraverso procedure giudiziarie, il trattamento riservato ai moderatori dei contenuti di Facebook. Se dovessero avere successo, potrebbero portarne molti altri nei luoghi in cui Meta e altri fornitori di social media controllano i contenuti attraverso fornitori terzi, migliorando potenzialmente le condizioni di migliaia di lavoratori pagati relativamente poco per esporsi al peggio dell'umanità.

moderatori

moderatori

Proprio come la sgobba sui pavimenti delle fabbriche o l'inalazione di polvere di carbone distruggevano i corpi dei lavoratori nell'era industriale, dicono gli avvocati dei moderatori, così coloro che lavorano nella fabbrica digitale dei social media rischiano di vedersi rovinare la mente.

"Si tratta di questioni di prima linea per i diritti del lavoro di questa generazione", afferma Neema Mutemi, docente dell'Università di Nairobi che sta contribuendo a pubblicizzare il caso. Alla richiesta di rispondere alle accuse, Meta ha risposto che non commenta le cause in corso.

Danni online

moderatore facebook

moderatore facebook

Negli ultimi anni, Meta ha subito crescenti pressioni per moderare il vetriolo e la disinformazione sulle sue piattaforme, che includono Facebook, WhatsApp e Instagram.

In Myanmar ha dovuto affrontare le accuse di aver amplificato con i suoi algoritmi i discorsi d'odio e di non aver rimosso i post che incitavano alla violenza contro la minoranza Rohingya, migliaia dei quali sono stati uccisi e centinaia di migliaia sono fuggiti in Bangladesh.

In India, gli esperti hanno affermato che non è riuscita a sopprimere la disinformazione e l'incitamento alla violenza, provocando disordini nel Paese, il suo più grande mercato singolo.

Nel 2021, la whistleblower Frances Haugen ha fatto trapelare migliaia di documenti interni che rivelavano l'approccio dell'azienda alla protezione dei suoi utenti e ha dichiarato al Senato degli Stati Uniti che l'azienda dava priorità al "profitto piuttosto che alla sicurezza".

moderatore di facebook a manila

moderatore di facebook a manila

Meta non è riuscita in particolare a filtrare i contenuti divisivi e a proteggere gli utenti di Paesi non occidentali come l'Etiopia, l'Afghanistan e la Libia, come dimostrano i documenti, anche quando la ricerca di Facebook li ha classificati come "ad alto rischio" a causa della fragilità del loro panorama politico e della frequenza dei discorsi di odio.

Negli ultimi anni, Meta ha investito miliardi di dollari per affrontare i danni nelle sue app, assumendo circa 40.000 persone per lavorare sulla sicurezza, molte delle quali contrattate attraverso gruppi di outsourcing di terze parti come Accenture, Cognizant e Covalen.

Si stima che 15.000 siano moderatori di contenuti. Al di fuori degli Stati Uniti, Meta collabora con aziende in più di 20 siti in tutto il mondo, tra cui India, Filippine, Irlanda e Polonia, che ora aiutano a vagliare i contenuti in più lingue straniere.

moderatori facebook

moderatori facebook

Nel 2019 Meta ha chiesto a Sama - che da diversi anni lavora a Nairobi sull'etichettatura dei dati per addestrare il software di intelligenza artificiale per clienti come Meta e Tesla - di occuparsi della moderazione dei contenuti. La società farà parte di un nuovo hub africano, che si concentrerà sul filtraggio dei contenuti in lingua africana.

Sama afferma di non aver mai svolto questo tipo di lavoro in precedenza. Ma il suo team in loco ha appoggiato l'assunzione del lavoro, che altrimenti sarebbe andato alle Filippine, per il senso di responsabilità di apportare competenze culturali e linguistiche alla moderazione dei contenuti africani. L'azienda ha iniziato ad assumere persone provenienti da paesi come Burundi, Etiopia, Kenya, Somalia, Sudafrica e Uganda per farle lavorare presso le sue strutture a Nairobi.

Si è rivelato un errore. Dopo quattro anni dall'avvio dell'attività di moderazione dei contenuti, Sama decise di uscire dal business, ponendo fine al contratto con Facebook e licenziando alcuni dei manager che avevano supervisionato il nuovo lavoro.

MOGOL BORDELLO - BY EMILIANO CARLI

MOGOL BORDELLO - BY EMILIANO CARLI

Brownie, che era stato assunto nel 2019 in Sudafrica per lavorare nell'hub di Nairobi, è stato tra coloro che hanno dato il preavviso questo gennaio, quando Sama ha comunicato ai suoi dipendenti che non avrebbe più moderato i contenuti di Facebook.

"È un lavoro importante, ma credo che stia diventando piuttosto impegnativo", ha dichiarato al FT Wendy Gonzalez, amministratore delegato di Sama, aggiungendo che la moderazione dei contenuti ha rappresentato solo il 2% delle attività di Sama. "Abbiamo scelto di uscire da questa attività nel suo complesso".

Molti dei moderatori che lavorano in Kenya dicono che il lavoro li lascia psicologicamente segnati, tormentati da flashback e incapaci di mantenere normali relazioni sociali.

"Una volta che l'hai visto non puoi più vederlo. Molti di noi ora non riescono a dormire", dice Kauna Ibrahim Malgwi, una nigeriana laureata in psicologia che ha iniziato a lavorare presso l'hub di Sama a Nairobi nel 2019 e moderava contenuti nella lingua Hausa parlata in tutta l'Africa occidentale. Ora sta prendendo degli antidepressivi, dice.

meta 7

meta 7

Cori Crider, direttrice di Foxglove, uno studio legale no-profit con sede a Londra che sta sostenendo gli ex moderatori di Sama, afferma che i moderatori ricevono una protezione del tutto inadeguata dallo stress mentale.

"I poliziotti che indagano su casi di immagini di abusi su minori hanno un'armata di psichiatri e limiti severi sulla quantità di materiale che possono vedere", dice. Ma i consulenti assunti da Sama per conto di Meta "non sono qualificati per diagnosticare o trattare il disturbo post-traumatico da stress", sostiene la donna. "Questi coach ti dicono di fare la respirazione profonda e di dipingere con le dita. Non sono professionali".

La Sama afferma che tutti i consulenti assunti avevano qualifiche professionali keniote.

Meta ha sostenuto che i tribunali del Kenya non avevano giurisdizione sul caso. Ma il 20 aprile, in quella che i moderatori e i loro avvocati considerano una grande vittoria, un giudice keniota ha stabilito che Meta può essere citata in giudizio nel Paese. Meta sta facendo appello.

MARK ZUCKERBERG

MARK ZUCKERBERG

"Se la Shell venisse a scaricare al largo delle coste del Kenya, sarebbe ovvio se il Kenya ha giurisdizione o meno", afferma Mercy Mutemi, avvocato keniota dello studio Nzili and Sumbi Advocates, che rappresenta i moderatori. "Non si tratta di un oggetto fisico e tangibile. Si tratta di tecnologia. Ma l'argomento è lo stesso. Sono venuti qui per fare del male".

Condizioni di lavoro

Il caso dei 184 moderatori è una delle tre cause intentate per conto dei moderatori di contenuti dallo studio legale di Mutemi con il sostegno di Foxglove.

La prima è stata presentata l'anno scorso per conto di Daniel Motaung, un moderatore sudafricano che lavora a Nairobi, contro Sama e Meta. Anche in quel caso, un giudice keniota ha respinto la tesi di Meta secondo cui i tribunali kenioti non avevano giurisdizione.

Motaung sostiene di essere stato licenziato ingiustamente dopo aver cercato di formare un sindacato per ottenere migliori condizioni di retribuzione e di lavoro. Sostiene inoltre di essere stato attirato nel lavoro con falsi pretesti, senza sapere esattamente cosa comportasse.

meta 6

meta 6

Sama contesta queste affermazioni, affermando che i moderatori di contenuti erano a conoscenza del lavoro durante il processo di assunzione e formazione e che Motaung è stato licenziato perché aveva violato il codice di condotta dell'azienda. "Per quanto riguarda la formazione di un sindacato, abbiamo delle politiche per la libertà di associazione", afferma Gonzalez. "Se si è formato un sindacato, non è un problema".

I moderatori di contenuti reclutati al di fuori del Kenya venivano pagati circa 60.000 Ks al mese, inclusa un'indennità di espatrio, equivalente a circa 564 dollari al tasso di cambio del 2020.

I moderatori lavoravano in genere in turni di nove ore, con un'ora di pausa, due settimane di giorno e due settimane di notte. Al netto delle tasse, ricevevano una paga oraria di circa 2,20 dollari.

meta 5

meta 5

Sama dice che queste paghe sono diverse volte superiori al salario minimo ed equivalenti a quelle percepite dai paramedici kenioti o dagli insegnanti laureati. "Si tratta di salari significativi", afferma Gonzalez.

I dati suggeriscono che i salari dei lavoratori espatriati sono poco più di quattro volte il salario minimo del Kenya, ma Crider di Foxglove dice di non essere impressionata: "2,20 dollari l'ora per sottoporsi a ripetuti filmati di omicidi, torture e abusi sui bambini? È una miseria".

Haugen, il whistleblower di Facebook, ha detto che la lotta di Motaung per i diritti dei lavoratori è l'equivalente dell'era digitale delle lotte precedenti. "Le persone che lottano l'una per l'altra sono il motivo per cui abbiamo la settimana lavorativa di 40 ore", ha detto Haugen, intervenendo a un evento con Motaung a Londra l'anno scorso. "Dobbiamo estendere questa solidarietà al nuovo fronte, su cose come le fabbriche di moderazione dei contenuti".

meta 4

meta 4

Questo mese, i moderatori di Nairobi hanno votato per formare quello che, secondo i loro avvocati, è il primo sindacato di moderatori di contenuti al mondo. Motaung ha definito la risoluzione "un momento storico".

L'ultima delle tre cause in corso in Kenya non riguarda il diritto del lavoro, ma le presunte conseguenze del materiale pubblicato su Facebook. Il caso sostiene che l'incapacità di Facebook di gestire i discorsi d'odio e l'incitamento alla violenza ha alimentato la violenza etnica nei due anni di guerra civile in Etiopia, conclusasi a novembre.

Crider sostiene che i tre casi sono collegati perché il trattamento inadeguato dei moderatori di contenuti si traduce direttamente nella diffusione di contenuti non sicuri senza controllo da parte delle piattaforme di Meta.

meta 3

meta 3

Uno dei due querelanti, il ricercatore Abrham Meareg, sostiene che suo padre, un professore di chimica, è stato ucciso nella regione Amhara dell'Etiopia nell'ottobre 2021 dopo che un post su Facebook ha rivelato il suo indirizzo e ha chiesto la sua uccisione. Abrham dice di aver chiesto più volte a Facebook di rimuovere il contenuto, senza successo.

Sama impiegava circa 25 persone per moderare i contenuti provenienti dall'Etiopia in tre lingue - amarico, tigrino e oromo - all'epoca di un conflitto che suscitava animosità etnica e che potrebbe aver causato fino a 600.000 vittime.

Gli avvocati chiedono l'istituzione di un fondo per le vittime di 1,6 miliardi di dollari e migliori condizioni per i futuri moderatori dei contenuti. Inoltre, chiedono di modificare l'algoritmo di Facebook per evitare che in futuro si verifichino altri casi.

Gli avvocati sostengono che per competere con le altre piattaforme, Facebook massimizza deliberatamente il coinvolgimento degli utenti a scopo di lucro, il che può favorire la diffusione di contenuti pericolosi o non sicuri.

"Abrham non è un caso isolato o un'eccezione", afferma Rosa Curling, direttore di Foxglove. "Ci sono infiniti esempi di cose pubblicate su Facebook, [inviti a uccidere] persone. E poi questo, di fatto, accade".

mark zuckerberg annuncia meta il nuovo nome di facebook

mark zuckerberg annuncia meta il nuovo nome di facebook

Curling afferma che la qualità della moderazione di Facebook nell'hub di Nairobi è influenzata dalle pratiche di lavoro ora contestate in tribunale.

Gonzalez di Sama riconosce che la regolamentazione della moderazione dei contenuti è carente, ma afferma che la questione dovrebbe essere "al centro dell'attenzione" dei responsabili delle aziende di social media. "Queste piattaforme, e non solo questa [Facebook] in particolare, ma anche le altre, sono un po' in libertà", afferma. "È necessario che ci siano controlli, equilibri e protezioni".

Sebbene Meta abbia in appalto decine di migliaia di moderatori umani, sta già investendo molto nel loro sostituto: un software di intelligenza artificiale in grado di filtrare la disinformazione, l'incitamento all'odio e altre forme di contenuti tossici sulle sue piattaforme. Nell'ultimo trimestre, l'azienda ha dichiarato che il 98% dei "contenuti violenti e grafici" eliminati è stato rilevato grazie all'intelligenza artificiale.

meme su meta il nuovo nome di facebook

meme su meta il nuovo nome di facebook

Tuttavia, i critici sottolineano che la grande quantità di contenuti dannosi che rimangono online in luoghi come l'Etiopia è la prova che il software di intelligenza artificiale non è ancora in grado di cogliere le sfumature necessarie per moderare le immagini e il linguaggio umano.

Non è un lavoro normale

Oltre a costituire potenzialmente un precedente legale, i casi in Kenya offrono un raro sguardo sulla vita lavorativa dei moderatori di contenuti, che normalmente lavorano nell'anonimato.

Gli accordi di non divulgazione che sono tenuti a firmare, di solito per volere di appaltatori come Sama, vietano loro di condividere i dettagli del loro lavoro anche con le loro famiglie. Gonzalez dice che questo serve a proteggere i dati sensibili dei clienti.

Frank Mugisha, un ex dipendente della Sama in Uganda, ha un'altra spiegazione. "Non ho mai avuto la possibilità di condividere la mia storia con nessuno perché sono sempre stato tenuto come uno sporco segreto", dice.

meta il nuovo nome di facebook

meta il nuovo nome di facebook

In seguito alla perdita del posto di lavoro, i dipendenti di Sama provenienti da fuori del Kenya rischiano ora di essere espulsi dal Paese, anche se un tribunale ha emesso un'ingiunzione provvisoria che impedisce a Meta e Sama di rescindere i contratti dei moderatori fino a quando non verrà emessa una sentenza sulla legalità del loro licenziamento.

Tuttavia, diversi ex dipendenti di Sama non sono stati pagati da aprile, quando l'azienda ha rescisso il contratto con Meta, e rischiano lo sfratto per il mancato pagamento dell'affitto.

Tutti i moderatori di contenuti che hanno parlato con il FT hanno firmato accordi di non divulgazione. Ma i loro avvocati hanno dichiarato che questi non impediscono loro di parlare delle loro condizioni di lavoro.

mark zuckerberg annuncia meta il nuovo nome di facebook 1

mark zuckerberg annuncia meta il nuovo nome di facebook 1

I moderatori provenienti da diversi Paesi africani sono stati coerenti nelle loro critiche. Tutti hanno detto di aver accettato il lavoro senza essere stati adeguatamente informati su ciò che comportava. Tutti hanno lamentato la costante pressione dei manager a lavorare in fretta, con l'obbligo di trattare ogni "ticket", o articolo, in 50 o 55 secondi.

Meta ha dichiarato di non imporre quote ai revisori dei contenuti e ha detto che "non sono costretti a prendere decisioni affrettate", anche se ha affermato che "efficienza ed efficacia" sono fattori importanti nel lavoro.

Malgwi, laureato in psicologia in Nigeria, non vede di buon occhio quello che i moderatori sostengono essere il tentativo di Facebook di mantenere le distanze ricorrendo a società terze come Sama. "Ci colleghiamo ogni mattina alla piattaforma di Meta", dice. "Vedete: 'Benvenuti. Grazie per aver protetto la comunità di Meta'".

Fasica Gebrekidan, moderatrice etiope che ha studiato giornalismo all'università di Mekelle, ha trovato lavoro alla Sama poco dopo essere fuggita dalla guerra civile etiope nel 2021. Dopo aver saputo che avrebbe lavorato indirettamente per Meta, ha pensato "forse sono la ragazza più fortunata del mondo", dice. "Non mi aspettavo che ogni giorno ci fossero corpi smembrati a causa degli attacchi dei droni", aggiunge.

Facebook Metaverso 4

Facebook Metaverso 4

Finora Gebrekidan non ha parlato con nessuno, nascondendo la natura del suo lavoro persino a sua madre. "So che quello che faccio non è un lavoro normale", dice. "Ma mi considero un'eroina per aver filtrato tutte queste cose tossiche e negative".