FLASH! - JORDAN BARDELLA PENSA ALLE ELEZIONI PRESIDENZIALI DEL 2027 E SI SPOSTA AL CENTRO: IL…

Simone Cosimi per “repubblica.it”

L'ultimo caso in Italia si è creato attorno a Michele Rech, meglio noto come Zerocalcare per un post che ha scatenato una sassaiola verbale sul suo account social tale da fare scattare l'oscuramento su Facebook. Tutto è successo a causa dell'annuncio da parte del disegnatore della sua partecipazione a un'iniziativa di Genova in ricordo di Carlo Giuliani nell’anniversario del G8. Per riaprire la sua popolarissima pagina, il fumettista ha dovuto rimuovere quell’elemento.

Al di là dell'avvenimento specifico e tutto italiano, che ruota intorno ai fatti drammatici avvenuti 15 anni fa e all’assassinio di Giulian - una partita che secondo Zerocalcare ''non è finita'' -, la vicenda torna ad aprire il dibattito sul meccanismo che regola il ''blocco'' dei contenuti ritenuti non rispettosi della policy imposta dal social network. E, quindi, anche una serie di interrogativi sull'effettiva efficacia degli strumenti messi a disposizione della piattaforma di Menlo Park per proteggere e tutelare la propria community.

A monte di tutto c'è la segnalazione. È in base a questa che l'azienda procede poi alla disattivazione del profilo, in attesa che vengano rimossi i post (testi, foto, video) ritenuti non corretti e per questo segnalati da altri utenti. Per farlo, bisogna cliccare sul tool ''Segnala il post'', disponibile aprendo il menu in alto a destra di ogni contenuto rilanciato sulla piattaforma.

Ma quali sono i contenuti che Facebook mette nel mirino e che dunque si prestano, più di altri, alla rimozione effettuata sia automaticamente che dopo una serie di segnalazioni da parte degli utenti? Si va dalle minacce alla protezione della proprietà intellettuale passando per contenuti di nudo, di incitamento all’odio (lo sterminato perimetro del cosiddetto hate speech) fino a contenuti violenti e immagini forti sui quali spesso il riconoscimento automatico delle immagini, cioè l’intelligenza artificiale della piattaforma, lascia a desiderare.

In mezzo c’è ovviamente anche altro: gli standard della comunità non accettano infatti testi, foto, video e altri elementi di autolesionismo, bullismo e d’intimidazione così come attacchi a personaggi pubblici, oltre ad attività criminali, violenza e sfruttamento sessuale. Questo nella teoria, perché nella pratica Facebook purtroppo ospita ogni giorno account falsi che tentano adescamenti e ricatti, virus e catene di Sant'Antonio, pagine d'incitamento all'odio razziale e così via.

Nulla che, in questo caso, toccasse da vicino il post di Zerocalcare. Ciò che infatti dimostra di non funzionare a dovere è proprio il criterio delle segnalazioni, che può chiaramente diventare pretestuoso. Perché il tool in questione può trasformarsi in un randello digitale a disposizione di ronde altrettanto digitali di disturbatori, hater, tifosi di una o dell’altra posizione in centinaia di situazioni diverse. Insomma, da pacifico meccanismo di tutela – per segnalare contenuti offensivi, spam, fastidiosi e ingiuriosi – può trasformarsi in censura.

Non accade solo in casi del genere, per così dire ''privati''. Quello strumento, oltre ad essere attivato in casi di nudo a causa della policy sessuofobica del social di Menlo Park o di linguaggio inappropriato, è stato in alcuni casi sfoderato da regimi più o meno autoritari con un'autentica pioggia di notifiche ai contenuti pubblicati da elementi sgraditi, attivisti o giornalisti.

Sul social network oltre alla censura diretta, legata a richieste precise dei governi sui quali il gruppo come altri pubblica ogni anno un rapporto, ne esiste una più subdola, in grado di piegare al proprio servizio uno strumento pensato per altri scopi. Senza che l'azienda proprietaria entri troppo nel merito per valutare la sensatezza di quelle segnalazioni.

La chiave del problema, sia che si tratti di un post di nudo magari d’arte (non si contano le riproduzioni di grandi opere eliminate), un contenuto legittimo segnalato per questioni ideologiche o un altro che effettivamente meriti di essere rimosso, è proprio questa: chi decide? Chi si fa interprete di quegli standard della comunità? Già nel 2012 il Guardian e la rivista Gawker avevano rivelato l’esistenza di lavoratori precari e sottopagati reclutati attraverso piattaforme di microlavori come oDesk, oggi ribattezzata Upwork, che per pochi dollari l’ora si sobbarcano il giudizio sulla pachidermica mole quotidiana di segnalazioni che arrivano da tutto il mondo.

Secondo un rapporto dell’Unesco datato 2014, e battezzato ''Fostering Freedom Online'', il social network di Mark Zuckerberg non si appoggerebbe più a quella piattaforma esterna ma ad altre che offrono servizi simili. Un lavoro sporco affidato d'altronde in outsourcing da tutte le piattaforme simili.

L’esito? A decidere se un post politico in Thailandia, così come la locandina postata da Zerocalcare, siano effettivamente elementi da rimuovere, spesso con conseguente sospensione del profilo privato o pubblico, c’è questa sorta d’intelligenza collettiva che potrebbe non avere le competenze né l'autorevolezza per eseguire un ''comando'' tanto significativo in termini di libertà d’opinione, qual è l'oscuramento di una pagina di Fb.

Le notizie su cosa accada dopo che un certo numero di segnalazioni sia ritenuto degno di attenzione, cioè su chi prenda in carico quell’evento (ossia il ''reactive moderating''), non sono molte. I colossi della Silicon Valley non amano parlare molto del ''dark side of the wall''.

Nel numero di novembre 2014 dell’edizione statunitense di Wired si raccontava di uffici di società per esempio nelle Filippine (scelte non a caso per l’ancora forte vicinanza alla sensibilità statunitense in termini di contenuti inappropriati) che si occupano di moderare i contenuti per l’allora molto in voga social anonimo Whisper e per altre piattaforme californiane. Secondo una stima, si tratta di un esercito di 100mila persone, specialmente in quell'area del mondo ma non solo, a sorbirsi il peggior sottoscala dei social network per ritrovarsi di fronte post e contenuti da censurare o meno.

La versione di Facebook. ''Non importa se un post riceve una o migliaia di segnalazioni, il contenuto viene sempre analizzato nello stesso modo per verificare se violi o meno i Community Standards, per questo i contenuti sono esaminati 24 ore al giorno, sette giorni su sette''. Ma cosa accade dopo che un contenuto ha ricevuto una serie di segnalazioni?

Chi se ne occupa? Difficile capirlo con precisione: Facebook parla tuttavia di ''partner accuratamente selezionati'' senza fare nomi: ''I Community Standards di Facebook vietano l’hate speech, il terrorismo, minacce specifiche di violenza e bullismo – aggiungono dal quartier generale milanese – la piattaforma continua a crescere e noi continuiamo a investire nei nostri team e a lavorare con partner accuratamente selezionati e affidabili per fare in modo che questi standard vengano applicati in modo coerente ed efficace. Il nostro personale altamente qualificato è basato in tutto il mondo e lavora sotto la guida della nostra sede internazionale di Dublino.

Fanno parte del personale molte persone madrelingua, tra cui persone italiane, perché sappiamo che spesso ci vuole un madrelingua per capire il vero significato delle parole''.

FLASH! - JORDAN BARDELLA PENSA ALLE ELEZIONI PRESIDENZIALI DEL 2027 E SI SPOSTA AL CENTRO: IL…

DAGOREPORT - MENTRE LA PROCURA DI MILANO, DOPO AVER ISCRITTO SUL REGISTRO DEGLI INDAGATI…

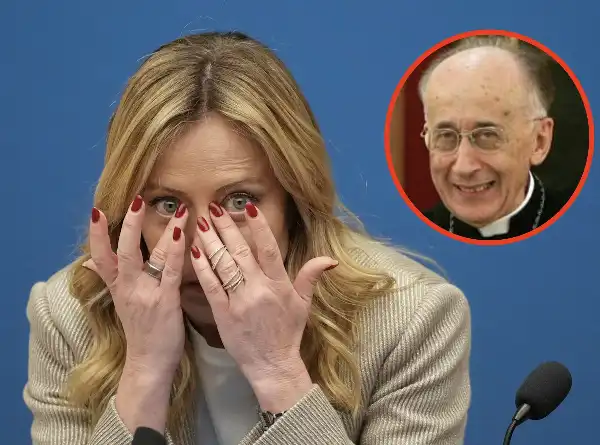

FLASH – PERCHÉ GIORGIA MELONI HA UN INFERMIERE CHE ABITUALMENTE VA DA LEI? IL CARDINAL CAMILLO…

DAGOREPORT – COSA, E CHI, HA CONVINTO SERGIO MATTARELLA A PRESIEDERE, PER LA PRIMA VOLTA IN 11 ANNI…

DAGOREPORT – A FORZA DI FARE IL "MAGGIORDOMO" DI CASA MELONI, ANTONIO TAJANI È FINITO IN CUL DE SAC …

FLASH! – IERI È STATO SVENTATO IL PROPOSITO DI GIAMPAOLO ROSSI DI DIMETTERSI DAL VERTICE DEL…