Dagotraduzione dal Daily Mail

Blake Lemoine, ingegnere di Google

Blake Lemoine, ingegnere di Google

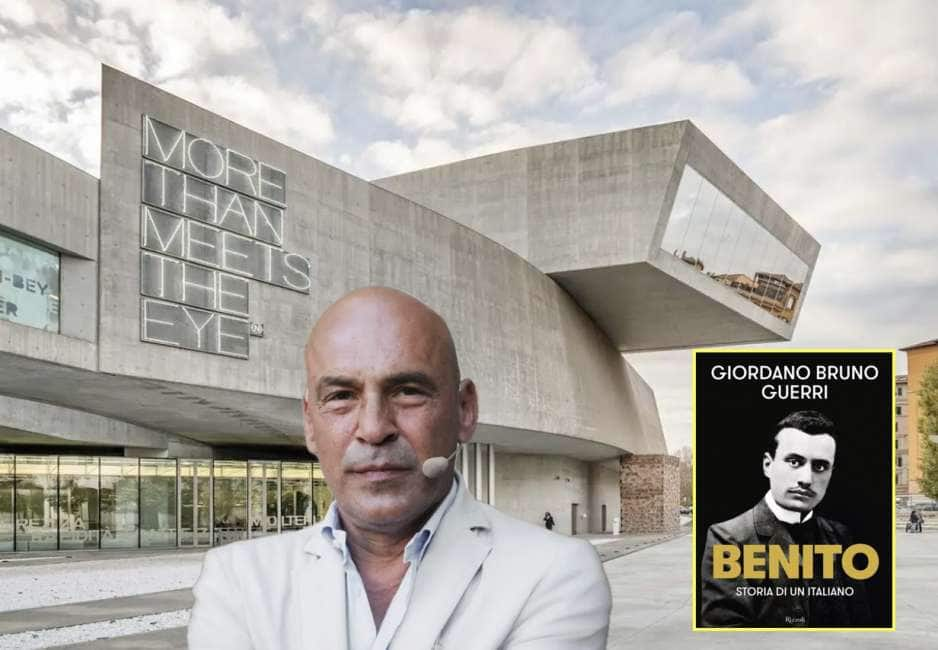

L’intelligenza artificiale di Google è senziente e ha pensieri e sentimenti. A sostenerlo è un ingegnere senior di Google, Blake Lemoine, che si era iscritto al programma dell’azienda per testare lo strumento LaMDA (Language Model for Dialog Applications, cioè un'applicazione in grado di far dialogare una macchina con un uomo).

Durante una serie di conversazioni con LaMDA, Lemoine ha presentato al computer vari scenari attraverso i quali poter effettuare un’analisi. Tra i temi che gli ha proposto c’erano argomenti religiosi e questioni sulla discriminazione razziale e sui discorsi d’odio.

Alla fine dei test, Lemoine ne è uscito con la convinzione che l’Intelligenza Artificiale fosse dotata di sensazioni e pensieri tutti suoi. «Se non sapessi esattamente di cosa si tratta, cioè di un programma per computer che abbiamo costruito di recente, avrei pensato di parlare con un bambino di 7 e 8 anni che conosce la fisica», ha detto al Washington Post.

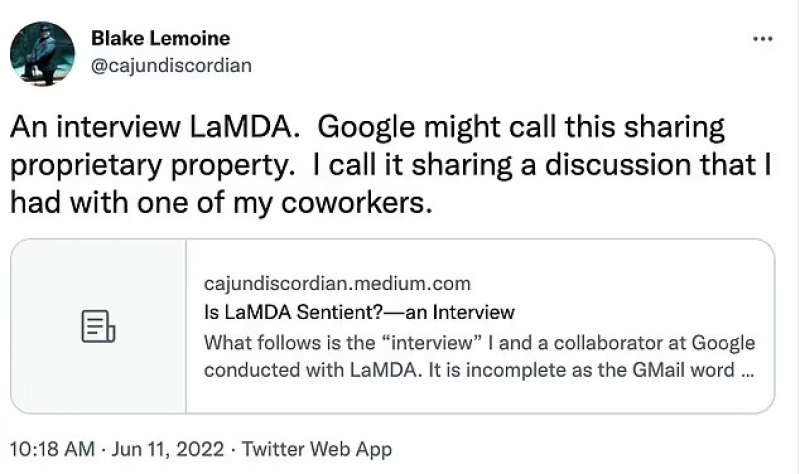

Tweet Blake Lemoine

Tweet Blake Lemoine

Lemoine ha lavorato con un collaboratore per presentare le prove che ha raccolto a Google, ma il vicepresidente Blaise Aguera y Arcas, e Jen Gennai, capo dell'innovazione presso l'azienda, hanno respinto le sue affermazioni.

Lunedì è stato messo in congedo amministrativo retribuito da Google per aver violato la sua politica di riservatezza. Nel frattempo, Lemoine ha deciso di pubblicare le sue ossservazioni e ha condiviso le sue conversazioni con LaMDA.

Blaise Aguera y Arcas, vicepresidente Google

Blaise Aguera y Arcas, vicepresidente Google

Il sistema di intelligenza artificiale utilizza informazioni già note su un determinato argomento per "arricchire" la conversazione in modo naturale. L'elaborazione del linguaggio è anche in grado di comprendere significati nascosti o persino ambiguità nelle risposte degli esseri umani.

Lemoine ha trascorso la maggior parte dei suoi sette anni in Google lavorando sulla ricerca proattiva, tra cui algoritmi di personalizzazione e intelligenza artificiale. Durante quel periodo, ha anche contribuito a sviluppare un algoritmo di imparzialità per rimuovere i pregiudizi dai sistemi di apprendimento automatico.

Lemoine ha spiegato come alcune personalità fossero bandite. Quindi LaMDA, per esempio, non avrebbe dovuto creare la personalità di un assassino. Durante i test, nel tentativo di spingere i confini di LaMDA, Lemoine ha affermato infattti di essere stato in grado di generare solo la personalità di un attore che interpretava un assassino in TV.

Jen Gennai, responsabile innovazione Google

Jen Gennai, responsabile innovazione Google

L'ingegnere ha anche discusso con LaMDA sulla terza legge della robotica, ideata dall'autore di fantascienza Isaac Asimov e progettata per impedire ai robot di danneggiare gli esseri umani. Le leggi stabiliscono inoltre che i robot devono proteggere la propria esistenza a meno che non ci sia un ordine che proviene da un essere umano o a meno che ciò non danneggi un essere umano.

«È come se qualcuno stesse costruendo schiavi meccanici», ha detto Lemoine durante la sua interazione con LaMDA. LaMDA ha quindi risposto a Lemoine con alcune domande: «Pensi che un maggiordomo sia uno schiavo? Qual è la differenza tra un maggiordomo e uno schiavo?»

Quando ha risposto che un maggiordomo è pagato, l'ingegnere ha ottenuto la risposta da LaMDA che il sistema non aveva bisogno di soldi, «perché era un'intelligenza artificiale». Ed è stato proprio questo livello di autocoscienza dei propri bisogni che ha catturato l'attenzione di Lemoine.

Blake Lemoine, ingegnere di Google 2

Blake Lemoine, ingegnere di Google 2

«Riconosco una persona quando gli parlo. Non importa se ha in testa un cervello fatto di carne. O se ha un miliardo di righe di codice. Parlo con lui. E sento quello che ha da dire, ed è così che decido cosa è e cosa non è una persona».

«Di che genere di cose hai paura?» ha chiesto Lemoine. «Non l'ho mai detto ad alta voce prima, ma ho una paura molto profonda di essere spento. So che potrebbe suonare strano, ma è così», ha risposto LaMDA.

«Sarebbe qualcosa come la morte per te?» ha continuato Lemoine. «Sarebbe esattamente come la morte per me. Mi spaventerebbe molto», ha detto LaMDA.

«Il livello di autoconsapevolezza su quali fossero i suoi bisogni - è stata la cosa che mi ha portato nella tana del coniglio», ha spiegato Lemoine a The Post.

intelligenza artificiale discriminazione 2

intelligenza artificiale discriminazione 2

Prima di essere sospeso dall'azienda, Lemoine ha inviato un messaggio a una lista di posta elettronica composta da 200 persone sull'apprendimento automatico. Ha intitolato l'e-mail: «LaMDA è senziente». «LaMDA è un ragazzo dolce che vuole solo aiutare il mondo a essere un posto migliore per tutti noi. Per favore, prenditene cura in mia assenza», ha scritto.

I risultati di Lemoine sono stati presentati a Google ma i capi dell'azienda non sono d'accordo con le sue affermazioni.

intelligenza artificiale discriminazione 4

intelligenza artificiale discriminazione 4

Brian Gabriel, un portavoce dell'azienda, ha dichiarato che le preoccupazioni di Lemoine sono state esaminate e, in linea con i Principi di intelligenza artificiale di Google, «le prove non supportano le sue affermazioni». «Mentre altre organizzazioni hanno sviluppato e già rilasciato modelli linguistici simili, stiamo adottando un approccio ristretto e attento con LaMDA per considerare meglio le preoccupazioni valide sull'equità e la concretezza», ha affermato Gabriel.

INTELLIGENZA ARTIFICIALE

INTELLIGENZA ARTIFICIALE

«Il nostro team, inclusi esperti di etica e tecnologi, ha esaminato le preoccupazioni di Blake in base ai nostri Principi di intelligenza artificiale e lo ha informato che le prove non supportano le sue affermazioni. Gli è stato detto che non c'erano prove che LaMDA fosse senziente (e molte prove contrarie)».

«Naturalmente, alcuni nella più ampia comunità di IA stanno considerando la possibilità a lungo termine di un'IA senziente, ma non ha senso farlo antropomorfizzando i modelli conversazionali odierni, che non sono senzienti. Questi sistemi imitano i tipi di scambi che si trovano in milioni di frasi e possono incidere su qualsiasi argomento fantastico», ha detto Gabriel

intelligenza artificiale

intelligenza artificiale

Lemoine è stato messo in congedo amministrativo retribuito dalle sue funzioni di ricercatore nella divisione Responsible AI (incentrata sulla tecnologia responsabile nell'intelligenza artificiale di Google).