DAGOREPORT – A UN MESE DAL REFERENDUM SULLA GIUSTIZIA, INEVITABILMENTE DIVENTATO IL GIORNO DEL…

L'IA DIVENTERA' COME "SKYNET" DI "TERMINATOR"? – OPENAI È IN CERCA DI UN “GUARDIANO” PER L’INTELLIGENZA ARTIFICIALE CHE DOVRÀ PREVENIRE GLI EFFETTI NEGATIVI DEI PROGRAMMI DI IA E SCOPRIRE SE L’ALGORITMO SIA DIVENTATO COSÌ INTELLIGENTE DA NASCONDERE LE SUE REALI INTENZIONI INGANNANDOCI – SAM ALTMAN SEMBRA TEMERE IL POTENZIALE IMPATTO CHE L’IA AVRÀ SULLA MENTE DEGLI UTENTI E SULLE NOSTRE DEMOCRAZIE – L’AZIENDA DI CHATGPT NON È LA PRIMA A CERCARE UNA FIGURA PROFESSIONALE DEL GENERE, MA A DIFFERENZA DEGLI ALTRI…

Estratto dell’articolo di Arcangelo Rociola per "la Stampa"

Lo stipendio base è di prima fascia anche per gli standard della Silicon Valley: 550 mila dollari per pensare tutto il tempo se e come l'uso dell'Intelligenza artificiale può finire male. […] La nuova posizione voluta da Sam Altman nella sua azienda è di rilievo assoluto. Avrà un potere decisionale che lo porrà tra i ruoli apicali.

Potrà porre il veto sul rilascio di nuovi modelli della società; dovrà analizzare le potenziali conseguenze nefaste di software; ma soprattutto dovrà essere in grado di capire l'Ai così a fondo da rendersi conto se lo sta prendendo in giro. È un tema cruciale per gli ingegneri.

[…] Lo chiamano misalignement/deception (disallineamento/inganno), ed è citato come requisito nel bando. OpenAI, temendo che prima o poi un'Ai possa diventare così intelligente da ingannare gli stessi suoi sviluppatori, magari mentendo sulle proprie capacità analitiche, o sulle proprie "intenzioni", cerca una figura che abbia una rara sintesi di capacità tecnica e intellettuale.

Deve sia saper leggere il codice che avere una raffinatezza di pensiero tale da capire se gli obiettivi del software siano "disallineati" da quelli degli sviluppatori stessi (quindi, si presume, dall'umanità e dal suo bene). E in più accorgersi se l'Ai è così intelligente da nascondere le sue reali intenzioni ingannandolo. OpenAi cerca un Head of Preparedness, tradotto, un responsabile della prevenzione dei rischi. Ma in realtà cerca un guardiano globale della tecnologia, che sappia quando tirare il freno a mano. […]

Altman sembra temere davvero per l'impatto che l'Ai avrà sulla mente dei suoi utilizzatori e sulle nostre democrazie. Peggio di quanto fanno i social network, capaci di scardinare comprensione dei testi, analisi critica e soglia dell'attenzione. Difficile dire al momento se si tratta di intenzioni serie o marketing.

La Silicon Valley oscilla sempre tra buone intenzioni e business, saltellando da una parte all'altra all'occorrenza. Ma è un fatto che molte delle principali aziende che si occupano di Ai si stanno dotando di strumenti e team di controllo. Anthropic, tra le più avanzate nella ricerca di un'Ai sicura, è stata la prima a dotarsi di un manuale di autolimitazione. Un sistema di controllo ogni volta che la potenza di calcolo aumenta di poco.

Google nel 2024 ha scelto un protocollo a soglie di pericolo, ad esempio su crimini informatici o manipolazione psicologica, impegnandosi a fermare gli sviluppi in caso di dubbi in fase di test. Meta ha un modello aperto: niente freni a mano, ma rilascio di codici aperti a milioni di ricercatori nella convinzione che il loro controllo sia il massimo per scoprire rischi e falle.

La decisione di OpenAI è più radicale. La prima del suo genere. Un'intelligenza umana come scudo per proteggersi da un'Ai potenzialmente malevola. Singolare sintesi di umanesimo e distopia, per alcuni arriva troppo tardi, troppo dopo le denunce di chatbot che aiutano adolescenti a togliersi la vita, uomini e donne a nascondere i propri disturbi e fobie, e società intere a perdere in stabilità e sicurezza sotto i colpi della disinformazione.

DAGOREPORT – A UN MESE DAL REFERENDUM SULLA GIUSTIZIA, INEVITABILMENTE DIVENTATO IL GIORNO DEL…

FLASH! - JORDAN BARDELLA PENSA ALLE ELEZIONI PRESIDENZIALI DEL 2027 E SI SPOSTA AL CENTRO: IL…

DAGOREPORT - MENTRE LA PROCURA DI MILANO, DOPO AVER ISCRITTO SUL REGISTRO DEGLI INDAGATI…

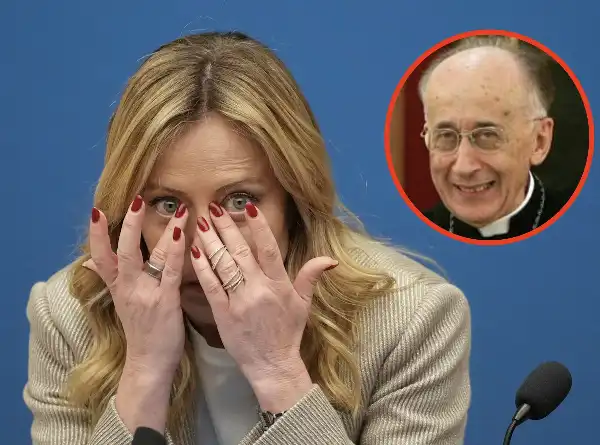

FLASH – PERCHÉ GIORGIA MELONI HA UN INFERMIERE CHE ABITUALMENTE VA DA LEI? IL CARDINAL CAMILLO…

DAGOREPORT – COSA, E CHI, HA CONVINTO SERGIO MATTARELLA A PRESIEDERE, PER LA PRIMA VOLTA IN 11 ANNI…

DAGOREPORT – A FORZA DI FARE IL "MAGGIORDOMO" DI CASA MELONI, ANTONIO TAJANI È FINITO IN CUL DE SAC …